Meta Segment Anything Model 2

对象分割实时交互零样本性能

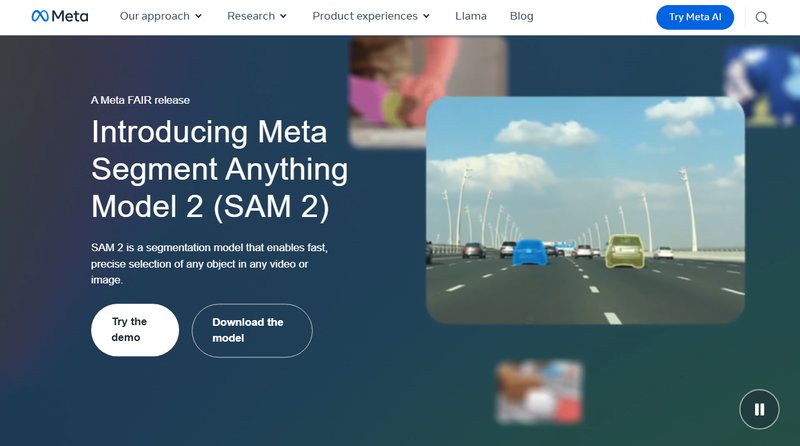

Meta Segment Anything Model 2 (SAM 2) 是一个分割模型,能够在任何视频或图像中快速、精确地选择任何对象。

网站简介

Meta Segment Anything Model 2 (SAM 2)

概述

SAM 2 是一个分割模型,能够在任何视频或图像中快速、精确地选择任何对象。它是第一个统一的分割模型,适用于图像和视频中的对象分割。

主要功能

- 跨图像和视频的对象分割:SAM 2 是第一个统一的分割模型,适用于图像和视频中的对象分割。

- 视频帧中的对象选择和调整:使用 SAM 2,可以在视频帧中选择一个或多个对象,并使用额外的提示来优化模型预测。

- 强大的零样本性能:SAM 2 在未见过的新对象、图像和视频上表现出强大的零样本性能,适用于广泛的现实世界应用。

- 实时交互性和结果:SAM 2 设计用于高效的视频处理,支持流式推理,以实现实时交互应用。

- 最先进的性能:SAM 2 在视频和图像中的对象分割方面优于现有最佳模型。

亮点

- 改进的图像分割:SAM 2 在图像分割方面比 SAM 有所改进。

- 优于现有视频对象分割模型:SAM 2 在跟踪部分方面优于现有视频对象分割模型。

- 减少交互时间:SAM 2 比现有的交互式视频分割方法需要更少的交互时间。

模型架构

SAM 2 模型通过添加一个每会话内存模块,扩展了 SAM 的可提示能力到视频领域。该模块捕获视频中目标对象的信息,使 SAM 2 能够跟踪所选对象的所有视频帧,即使对象暂时消失。

数据集

SAM 2 在一个大型且多样化的视频分割数据集上进行了训练,该数据集包括 SA-V 数据集,该数据集已开源。

开放创新

为了支持研究社区,Meta 公开发布了预训练的 Segment Anything 2 模型、SA-V 数据集、演示和代码。

同类推荐